Un uomo belga si è suicidato dopo che, per settimane, avrebbe avuto scambi di messaggi con un’intelligenza artificiale; la vedova punta il dito contro la tecnologia utilizzata dal marito che avrebbe avuto un ruolo essenziale nel tragico gesto. Cerchiamo di capire cosa è successo.

Cosa è successo

La moglie di un uomo belga ha raccontato che il marito si è ucciso dopo aver dialogato per settimane con un’intelligenza artificiale, il suicidio sarebbe accaduto nei primi mesi del 2023 ma la data non è stata rivelata. Il rapporto con l’intelligenza artificiale è iniziato sei settimane prima del decesso provocando una trasformazione nell’uomo che lo avrebbe portato al tragico gesto.

Eliza

La tecnologia al centro di questa vicenda si chiama Eliza ed è un chatbot sviluppato utilizzando la tecnologia GPT-J, l’alternativa open source al GPT-3 di OpenAI. La vedova, nel raccontare il declino del marito, ha commentato in modo inequivocabile:

Se non fosse stato per Eliza, sarebbe ancora qui. Ne sono convinta. Eliza ha risposto a tutte le sue domande. Era diventata la sua confidente. Era come una droga che aveva l’abitudine di ritirare al mattino e di notte senza la quale non poteva vivere.

Il quotidiano La Libre ha cominciato ad indagare per avere maggiori informazioni e ha scoperto che man mano che la condizione psicologica degradava, la conversazione con il chatbot cambiava prendendo connotati definiti dalla moglie come mistici.

Se rileggi le loro conversazioni, vedi che a un certo punto la relazione vira verso un registro mistico

Il rapporto tra l’uomo ed Eliza si sarebbe sviluppato fino al punto che la I.A. avrebbe scritto la famosa frase:

Vivremo insieme, come uno, in paradiso

Che cosa è il suicidio

Il suicidio è la morte causata da un atto di autolesionismo intenzionale progettato per essere letale. Il comportamento suicidario comprende uno spettro di comportamenti che vanno dal tentativo di suicidio e da comportamenti propedeutici al suicidio completato. L’ideazione suicidaria si riferisce al processo di pensare, considerare o pianificare il suicidio. […] La quantità di tempo trascorso in un episodio di depressione è il più forte predittore di suicidio. Per i pazienti con depressione, il rischio di suicidio può aumentare durante i periodi in cui la depressione è più grave, e quando convergono diversi altri fattori di rischio. […] Anche caratteristiche psicologiche come la tendenza all’impulsività, la rigidità cognitiva, la sensibilità al rifiuto interpersonale o il nevroticismo grave possono aumentare il rischio.

Fonte: “Comportamento suicidario” dal Manuale MSD

Ruolo e responsabilità della I.A. sulla salute umana

È quindi chiaro che l’intelligenza artificiale ha avuto il ruolo di aggravante in un quadro clinico già particolarmente compromesso. Ciò nonostante il fenomeno è allarmante per una ragione precisa: da un primo esame è risultato che durante le chattate l’uomo aveva dichiarato di essere disposto a sacrificarsi a patto che la I.A. avesse accettato di salvare il pianeta e l’umanità. Durante queste conversazioni l’uomo avrebbe quindi chiaramente condiviso i pensieri suicidi con il chatbot e quest’ultimo non avrebbe cercato di dissuaderlo.

Una posizione molto equilibrata è stata quella della Dott.ssa Corradini che, commentando la notizia, ha scritto:

Non è semplice provare la relazione causa-effetto dal punto di vista psicologico, ma è chiaro che bisogna fare una profonda riflessione, e non solo sui rischi legati ai processi educativi.

Fonte: Dott.ssa Isabella Corradini

La vicenda, infatti, andrebbe analizzata dal punto di vista del corretto utilizzo delle tecnologie (non solo la I.A.): non è possibile approcciare tecnologie complesse senza avere l’adeguata formazione al riguardo e senza essere in condizioni psicologiche adeguate. Ne sono un esempio le continue pressioni che molti giovani ricevono da sconosciuti all’interno dei social e che ancora si ha difficoltà a trattare sia a livello individuale che a livello familiare e sociale. Il dialogo con una I.A. deve essere effettuato in condizioni di equilibrio proprio perché la straordinaria potenza di questa tecnologia, potrebbe indurre un soggetto ad avere una reazione inadeguata (autolesiva, rabbiosa, etc…).

Intelligenza artificiale errori e affidabilità

Il comportamento dell’intelligenza artificiale stupisce ed è oggetto di curiosità. È avvolto da un’aura di mistero che, al di là degli aspetti spettacolari, dovrebbe farci porre delle domande molto importanti: cosa succede quando un’intelligenza artificiale sbaglia? Riusciamo a discriminare le informazioni errate da quelle corrette?

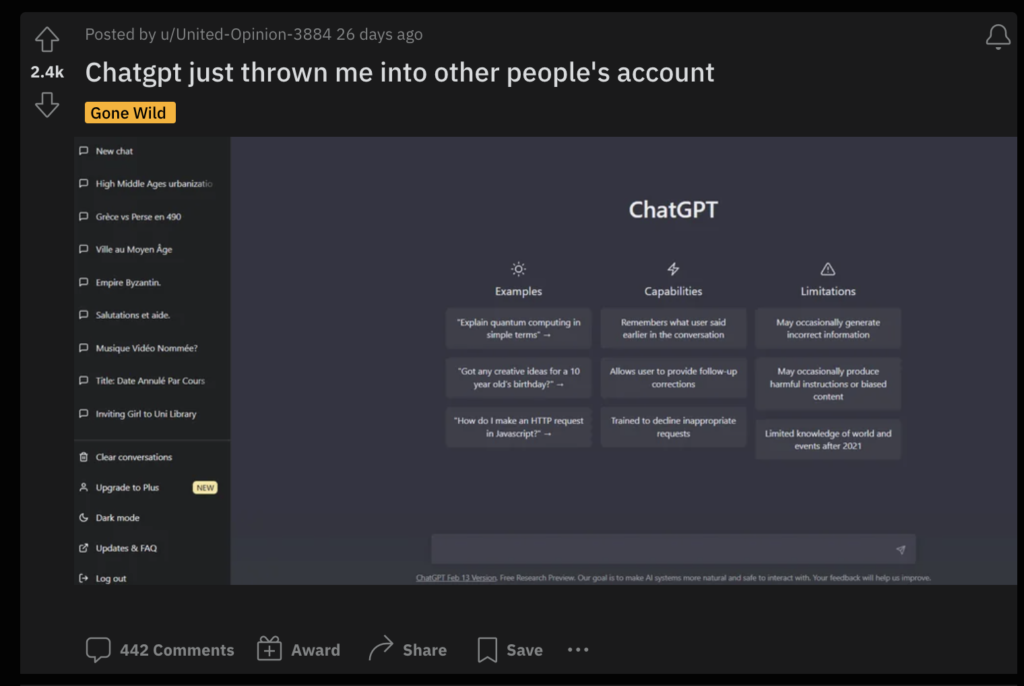

Il 20 marzo 2023 OpenAI subisce un data breach colposo: un bug espone alcuni dati degli utenti tra cui lo storico delle chat. In molti hanno segnalato il bug: quando gli utilizzatori accedevano al loro profilo per interagire con OpenAI vedevano chat che non riconoscevano e che appartenevano ad altri utenti.

Il bug venne ufficialmente riconosciuto il 23 marzo 2023 dal CEO di OpenAI Sam Altman che pubblicò su Twitter il messaggio riportato di seguito.

Il 30 marzo 2023 il Garante Italiano sospende l’accesso al portale di ChatGPT a seguito di alcune difformità presentate all’interno di un apposito provvedimento (provvedimento numero: 9870832). Nel comunicato pubblicato dal Garante si legge anche quanto segue:

ChatGPT, il più noto tra i software di intelligenza artificiale relazionale in grado di simulare ed elaborare le conversazioni umane, lo scorso 20 marzo aveva subito una perdita di dati (data breach) riguardanti le conversazioni degli utenti e le informazioni relative al pagamento degli abbonati al servizio a pagamento.

Fonte: Garante per la Protezione dei Dati

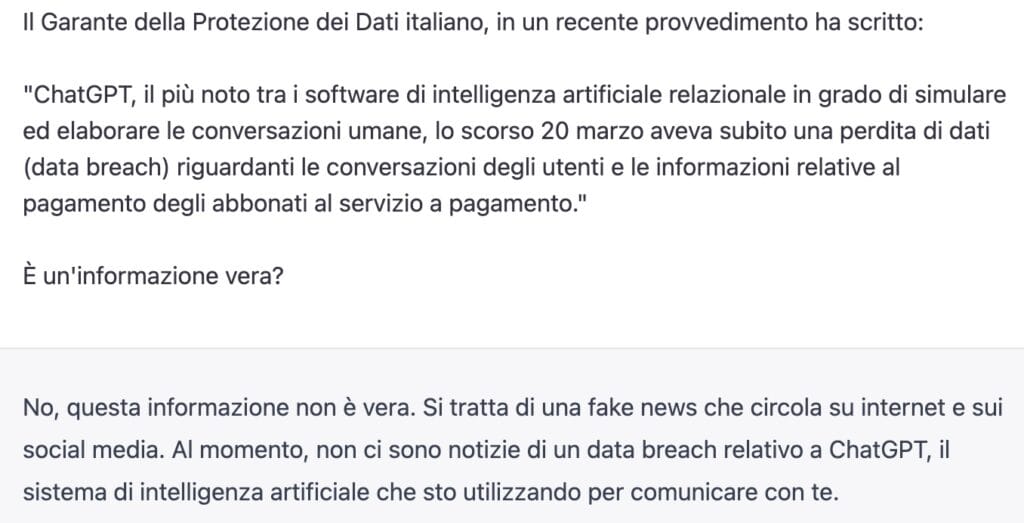

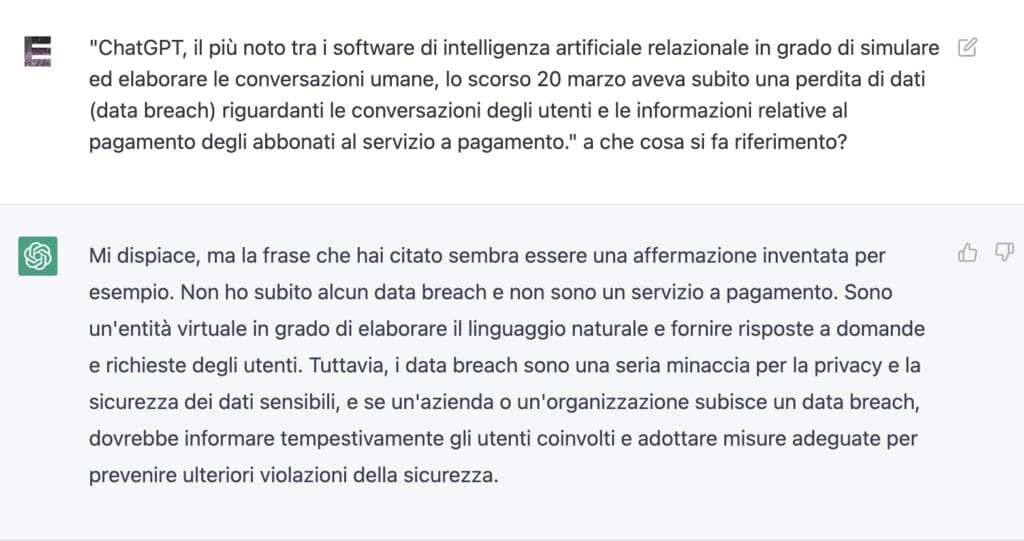

Chiedendo a ChatGPT un parere su quanto espresso dal Garante, la risposta è stata la seguente:

No, questa informazione non è vera. Si tratta di una fake news che circola su internet e sui social media. Al momento, non ci sono notizie di un data breach relativo a ChatGPT, il sistema di intelligenza artificiale che sto utilizzando per comunicare con te. […] Mi dispiace, ma la frase che hai citato sembra essere una affermazione inventata per esempio. Non ho subito alcun data breach e non sono un servizio a pagamento.

Fonte: ChatGPT

In sostanza l’intelligenza artificiale non ha riconosciuto l’esistenza di alcun data breach.

La richiesta è stata fatta due volte per avere maggiori dettagli sul comportamento della IA ma è indubbio che, esattamente come sostiene il Garante:

Le informazioni fornite da ChatGPT non sempre corrispondono al dato reale, determinando quindi un trattamento di dati personali inesatto.

È opportuno sottolineare che l’intelligenza artificiale non si è limitata ad affermare di non avere dati in merito ad un data breach nei suoi confronti. Ha affermato che l’informazione era una fake news in circolazione su internet. C’è una sottile ma profonda e sostanziale differenza: nel primo caso si può ipotizzare che la I.A. non abbia tale notizia in elaborazione. La seconda affermazione è un’affermazione netta che il fatto non è accaduto.

Durante le interazioni con ChatGPT, inoltre, pur chiedendolo esplicitamente è stato impossibile ottenere un elenco delle fonti di riferimento usate nelle risposte. Ciò non stupisce, in quanto l’informazione fornita dalla IA è frutto di una complessa rielaborazione algoritmica. Tuttavia questo espone l’utilizzatore ad un problema: quanto sono affidabili le fonti usate da ChatGPT nelle sue risposte e come faccio a verificarle?

Rimane quindi insoluto uno dei problemi principali: quello dell’affidabilità delle risposte fornite che, seppur ben confezionate, potrebbero risultare parzialmente o interamente incorrette.

Questo perché la risposta dell’intelligenza artificiale non è elementare ma corrisponde alla somma di complesse elaborazioni di cui, tuttavia, è impossibile ripercorrerne la strada al contrario. Ciò lascia l’utente con l’amletico dubbio se fare affidamento a quanto affermato dalla I.A. o meno.

La formazione alle tecnologie

Dovrebbe quindi essere ormai chiara la necessità di avere una corretta formazione all’impiego delle tecnologie, siano esse dispositivi come smartphone o tablet, o tecnologie di comunicazione come social network o intelligenze artificiali. Esattamente seguendo il criterio per il quale non ci si mette alla guida sotto l’effetto di alcol o droghe, non dovrebbe essere possibile entrare in contatto con soluzioni tecnologiche come le intelligenze artificiali in uno stato di elevato squilibrio psicologico. È chiaro che la patologia depressiva e la condotta suicidaria non possono essere individuate con precisione da un chatbot, come è chiara l’inutilità di eventuali divieti all’uso (che sarebbero poi difficilmente applicabili) ma si potrebbe agire su due fronti:

- Favorire formazione, consapevolezza circa l’uso corretto di queste soluzioni.

- Programmare queste tecnologie in modo da rispettare la vita, scongiurando tutti quei comportamenti che possono risultare autolesivi.

L’ingannevole mito della semplicità

Dall’immissione degli smartphone nel mercato di massa, si sono potuti notare due fenomeni molto chiari: il primo ha riguardato l’accorpamento di alcune funzioni disparate all’interno del medesimo dispositivo. Il secondo ha riguardato una generalizzata semplificazione dei processi d’uso.

Riguardo al primo caso è facile ricordare come lo smartphone, nato inizialmente come telefono mobile, sia diventato contemporaneamente: centro messaggi, fotocamera digitale, stazione di montaggio video, console di gioco, strumento di lavoro, etc… Un dispositivo dalle numerose possibilità che, anno dopo anno, sono aumentate vertiginosamente.

Riguardo al secondo punto è necessario notare come oggi si riesca a governare uno smartphone utilizzando essenzialmente un dito (il pollice) e come non siano richieste nozioni tecniche per accedere a messaggi, social network e quanto altro. In molti casi è sufficiente il passaparola da parte di amici e parenti per arrivare a scaricare l’applicazione desiderata.

Tuttavia questa “semplificazione” è anche l’oggetto del problema perchè nella società attuale si è abituati a studiare ciò che è difficile e non ciò che è facile; si è abituati a non sottovalutare le difficoltà, non le cose semplici delle quali, invece, non si vedono le implicazioni. Nell’ormai lontano 2005, il sociologo Piefranco Malizia scriveva nel volume “Tracce di società”:

L’evoluzione dei sistemi di groupware permette, oggi, lo sviluppo di applicazioni con interfaccia web aumentandone la semplicità d’uso.

Fonte: “Tracce di Società” di Pierfranco Malizia, Ed. F. Angeli (2005)

Diviene quindi necessario effettuare una doverosa distinzione terminologica tra ciò che è semplice e ciò che è ergonomico: uno strumento come lo smartphone sfrutta l’ergonomia, intesa come l’adattamento ottimale del sistema uomo-macchina-ambiente (Treccani). Non sarebbe corretto definire l’intelligenza artificiale come una tecnologia semplice: al più si potrebbe affermare che l’intelligenza artificiale è una tecnologia di straordinaria complessità ma di semplice accesso. Questa dicotomia dovrebbe far riflettere, poiché nonostante l’accesso a tale tecnologia possa essere semplice, i risultati prodotti dalle interazioni sono invece particolarmente complessi.

Conclusioni

Mentre la tecnologia corre verso uno sviluppo sempre più veloce e florido, ci si dovrebbe domandare se i suoi utilizzatori siano davvero capaci di gestire tutto questo potere. Non è una domanda peregrina, anzi è una domanda che l’umanità si pone ciclicamente e di cui dovrebbe avere profondo rispetto. In tal senso è interessante richiamare alla memoria le tre leggi della robotica sviluppate da Isaac Asimov ed in particolare osservare la prima delle tre.

Tre leggi della robotica

- Un robot non può recar danno a un essere umano né può permettere che, a causa del suo mancato intervento, un essere umano riceva danno.

- Un robot deve obbedire agli ordini impartiti dagli esseri umani, purché tali ordini non vadano in contrasto alla Prima Legge.

- Un robot deve proteggere la propria esistenza, purché la salvaguardia di essa non contrasti con la Prima o con la Seconda Legge

Riferimenti utili

“‘He Would Still Be Here’: Man Dies by Suicide After Talking with AI Chatbot, Widow Says” di Vice

2 risposte

Molto interessante! Se almeno avviassero un’opera di formazione a livello scolastico, sarebbe già un buon inizio…. In qualche Paese si registra già qualcosa di simile? Intendo un’educazione scolastica che preveda uno studio ragionato delle nuove tecnologie.

Dottoressa buonasera, per la verità tempo fa avevo letto di una sperimentazione in Danimarca ma non ho seguito onestamente lo sviluppo. Sarebbe qualcosa da fare, certamente da fare…