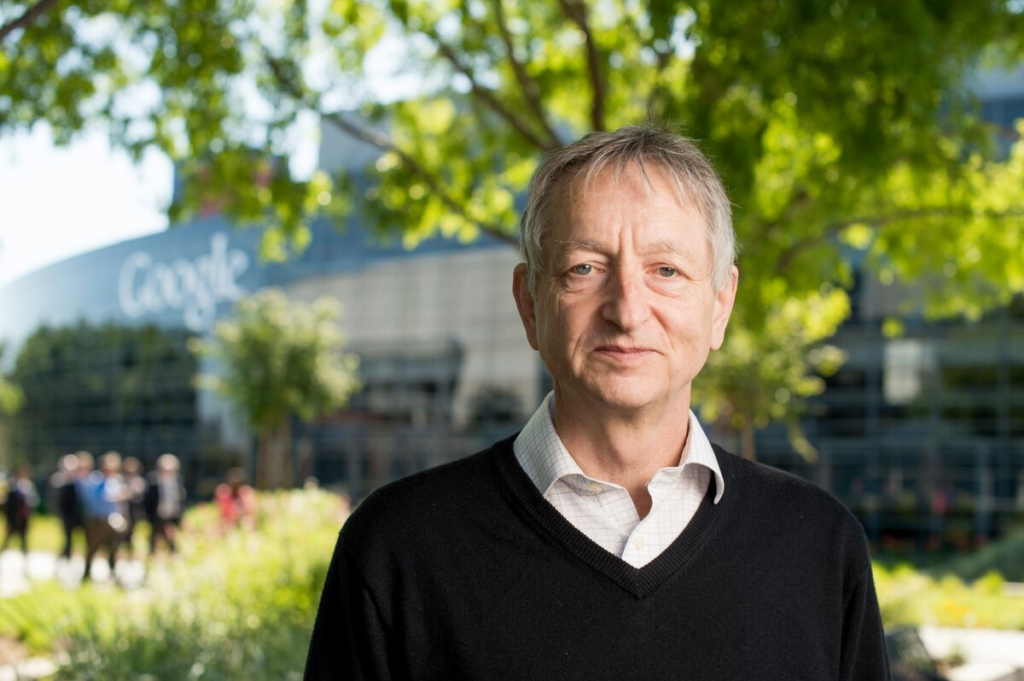

Una delle notizie del mese sono state le dimissioni di Geoffrey Hinton da Google che, a quanto si apprende dai giornali, sarebbero dipese dai timori provati nei confronti dell’ipersviluppo dell’intelligenza artificiale. Cerchiamo di saperne di più.

Chi è Geoffrey Hinton

Geoffrey Everest Hinton, classe ’47, è un informatico di nazionalità britannica. È particolarmente conosciuto per i suoi studi sulle meccaniche di apprendimento automatico che lo hanno portato ad essere tra i più noti in questo settore. Poiché Hinton è poco conosciuto da chi non è addetto ai lavori, è opportuno inquadrare bene la persona di cui stiamo parlando. Geoffrey Hinton è membro della Royal Society, della Royal Society of Canada e della Association for the Advancement of Artificial Intelligence. È membro straniero onorario dell’American Academy of Arts and Sciences e della National Academy of Engineering, ed ex presidente della Cognitive Science Society. Ha ricevuto lauree honoris causa dall’Università di Edimburgo, dall’Università del Sussex e dall’Università di Sherbrooke. Ha ricevuto il primo premio David E. Rumelhart (2001), il premio IJCAI per l’eccellenza nella ricerca (2005), il premio Killam per l’ingegneria (2012), la medaglia d’oro IEEE James Clerk Maxwell (2016) e la medaglia d’oro NSERC Herzberg (2010) che è il massimo riconoscimento del Canada per la Scienza e Ingegneria. Nel 2018 ha vinto il premio Turing proprio per aver condotto numerosi studi sull’apprendimento profondo (deep learning). È stato uno dei ricercatori che ha introdotto l’algoritmo di retropropagazione e il primo a utilizzare la retropropagazione per l’apprendimento di incorporamenti di parole.

Che cosa è l’apprendimento profondo

Con il termine intelligenza artificiale, solitamente s’intende includere tutta una serie di tecnologie che, in realtà, sono tra loro differenti e dipendenti l’una dall’altra. Nello specifico si fa riferimento a tre termini specifici che sono: Artificial Intelligence (intelligenza artificiale), Machine Learning (apprendimento automatico) e Deep Learning (apprendimento profondo). Il deep learning è quindi un sottoinsieme del machine learning che, a sua volta, è un sottoinsieme dell’artificial intelligence. Se provassimo a rappresentare graficamente il modello, dovremmo usare una gerarchia così disposta.

Artificial Intelligence (A.I.)

|

|-> Machine Learning (M.L.)

|

|-> Deep Learning (D.L.)

Per comprendere bene la differenza tra questi tre livelli bisogna tenere conto di alcune informazioni:

- Nei primi due livelli al sistema vengono forniti per lo più dati strutturati, pre-organizzati dall’uomo in modo che la macchina possa elaborare velocemente ma secondo logiche prestabilite. Nel terzo livello invece (il deep learning), il sistema è in grado di trovare autonomamente le risposte agli input e costruire nuove tassonomie sulla base di dati non necessariamente strutturati. Sarà il sistema a creare autonomamente strutture e tassonomie per rispondere all’input.

- Per poter arrivare al terzo livello, il sistema necessita di aver raggiunto i precedenti in modo efficace ed è questo che genera efficacia. Questa dipendenza dai livelli precedenti viene definita come rete multistrato.

La creazione di questi livelli dipende dagli studi compiuti sul funzionamento del cervello umano, per questa ragione il deep learning si basa sulle cosiddette reti neurali artificiali ossia dei modelli di calcolo matematici e statistici che simulano il comportamento delle reti neurali biologiche.

Che cosa è la backpropagation

Spiegare la backpropagation o retropropagazione dell’errore non è semplice, è conveniente iniziare dalla definizione efficace fornita dalla Treccani:

Metodo di progettazione delle reti neurali artificiali consistente in un meccanismo di apprendimento, detto con supervisione, attraverso una procedura ciclica di aggiornamento della matrice dei pesi sinaptici che attenua progressivamente, al termine di ogni ciclo, la discrepanza (o errore) fra risultato noto e risultato effettivo nel trattare una serie di casi esemplari. Le interazioni si arrestano quando la procedura converge, ovvero quando la discrepanza scende al di sotto di un limite prefissato. Non può essere tuttavia garantito che questo avvenga in tutti i casi. Al termine della fase di apprendimento, alla rete viene richiesto di risolvere un problema reale (a risposta incognita), utilizzando senza ulteriori modifiche la matrice dei pesi sinaptici ottimizzata in precedenza. L’algoritmo di retropropagazione richiede che la rete abbia un’architettura a strati e che il flusso dell’informazione proceda unidirezionalmente dall’input verso l’output. La scarsa verosimiglianza fisiologica di questa assunzione è compensata dal vantaggio di poter definire una funzione analoga all’energia che viene minimizzata durante l’apprendimento.

Fonte: Treccani

La backpropagation, o retropropagazione dell’errore in italiano, è quindi una metodologia assistita di apprendimento per le intelligenze artificiali. Le caratteristiche più importanti sono:

- La velocità: la backpropagation è veloce, semplice e facile da programmare.

- Non ha particolari parametri da regolare a parte i numeri di input che servono a creare il modello.

- È un metodo flessibile in quanto non richiede conoscenze pregresse sulla rete.

- È un metodo standard che generalmente funziona bene su tutte le reti.

- Non ha bisogno di alcuna menzione speciale delle caratteristiche della funzione da apprendere.

La retropropagazione è stata al centro degli studi di Hinton che di recente si è posto molte domande su questa metodologia, tra cui se il cervello umano la utilizzi oppure no. Hinton, in un certo senso lo spiega durante la prima parte dell’intervista rilasciata a “The Robot Brains”, di cui si riporta un estratto:

Ecco come funziona il tuo cervello. Ha molti piccoli elementi di elaborazione chiamati neuroni. E ogni tanto un neurone fa il ping. E ciò che fa suonare un ping è che sta ascoltando ping da altri neuroni e ogni volta che sente un ping da un altro neurone, aggiunge un po’ di peso a qualche riserva di input che ha. E quando lo riceve, quando ha abbastanza input, fa il ping. Quindi, se vuoi sapere come funziona il cervello, tutto ciò che devi sapere è come i neuroni decidono di regolare quei pesi che hanno quando arriva un ping. Questo è tutto quello che avete bisogno di sapere. Ci deve essere qualche procedura utilizzata per regolare i pesi. E se riusciamo a capirlo, sappiamo come funziona il cervello. […] La retropropagazione era già nota a diversi autori. Quello che abbiamo fatto veramente è stato dimostrare che poteva apprendere rappresentazioni interessanti. Quindi non è che abbiamo inventato la retropropagazione. Rumelhart ha davvero inventato la retropropagazione. Abbiamo dimostrato che può apprendere rappresentazioni interessanti, come, ad esempio, incorporamenti di parole.

Fonte: The Robot Brains – Episodio 22

Per chi volesse approfondire la backpropagation si raccomanda il video seguente.

Le ragioni delle dimissioni

La stampa italiana ha riportato la notizia delle dimissioni di Hinton ma con pochi dettagli rispetto a quanto avvenuto all’estero: una lunga e ben fatta intervista del New York Times è la fonte principale di riferimento e sarà la base delle riflessioni del presente articolo. Per comodità si riporterà il testo tradotto automaticamente in italiano, la versione originale è reperibile al link sopra indicato. Per prima cosa bisogna inquadrare la situazione attuale del problema e la ragione delle dimissioni.

Il Dr. Geoffrey Hinton lascia Google per poter condividere liberamente la sua preoccupazione che l’intelligenza artificiale possa causare gravi danni al mondo[…] Lunedì, tuttavia, si è ufficialmente unito a un crescente coro di critici che affermano che quelle aziende stanno correndo verso il pericolo con la loro campagna aggressiva per creare prodotti basati sull’intelligenza artificiale generativa, la tecnologia che alimenta popolari chatbot come ChatGPT.[…] Il dottor Hinton ha dichiarato di aver lasciato il suo lavoro in Google, dove ha lavorato per più di un decennio ed è diventato una delle voci più rispettate nel settore, quindi può parlare liberamente dei rischi dell’IA una parte di lui, ha detto, ora si rammarica del lavoro della sua vita. “Mi consolo con la solita scusa: se non l’avessi fatto io, l’avrebbe fatto qualcun altro”, ha detto il dottor Hinton durante una lunga intervista la scorsa settimana nella sala da pranzo della sua casa di Toronto, a pochi passi da dove lui e i suoi studenti hanno fatto la loro svolta. Il viaggio del Dr. Hinton da I.A. Da pioniere a catastrofista segna un momento straordinario per l’industria tecnologica, forse nel suo punto di svolta più importante degli ultimi decenni. I leader del settore credono che la nuova I.A. potrebbero essere importanti quanto l’introduzione del browser Web all’inizio degli anni ’90 e potrebbero portare a scoperte in aree che vanno dalla ricerca sui farmaci all’istruzione.

Fonte: New York Times

Il problema commerciale e i rischi

Le ragioni per cui le dimissioni non sono state date prima, sono di carattere sia commerciale che gestionale.

Fino all’anno scorso, ha affermato, Google ha agito come un “amministratore adeguato” per la tecnologia, attento a non rilasciare qualcosa che potrebbe causare danni. Ma ora che Microsoft ha potenziato il suo motore di ricerca Bing con un chatbot, sfidando il core business di Google, Google sta correndo per implementare lo stesso tipo di tecnologia. I giganti della tecnologia sono bloccati in una competizione che potrebbe essere impossibile fermare, ha affermato il dottor Hinton.

Fonte: New York Times

I timori che Hinton ha esplicitato al New York Times sono di due tipi, a breve termine e a lungo termine. La sua preoccupazione nell’immediato è che Internet sarà inondato di foto, video e testi falsi e la persona media “non sarà più in grado di sapere cosa è vero […] A differenza delle armi nucleari, ha detto, non c’è modo di sapere se aziende o paesi stanno lavorando in segreto sulla tecnologia“.

In effetti già oggi, periodo storico in cui l’intelligenza artificiale non è ancora largamente diffusa, c’è un problema di validità delle fonti, argomento caro a chi vuole proporre tematiche e argomenti di qualità. In queste settimane Amnesty International è stata molto criticata per aver divulgato immagini generate da un’intelligenza artificiale, per rafforzare i contenuti riguardanti le proteste del 2021 in Colombia.

Si possono notare diverse imperfezioni nell’immagine: dettagli mancanti sulle divise, volti poco definiti, colori posizionati in ordine sbagliato (i colori della bandiera della Colombia sono in ordine diverso). Tuttavia molte persone hanno creduto che la foto fosse reale: non hanno osservato, si sono limitate a vedere.

Le principali criticità

La scienza e le interferenze della politica

Thomas Mann una volta disse Tutto è politica e non è possibile pensare che sbagliasse: oggi tutto è politica e la scienza, che dovrebbe essere neutrale ma risulta condizionata. Basti pensare al luogo apparentemente più neutrale: la stazione spaziale internazionale, intorno alla quale in realtà si giocano tavoli geopolitici di elevato calibro. Hinton ne parla durante la sua intervista.

La migliore speranza è che i principali scienziati del mondo collaborino su modi per controllare la tecnologia. “Non credo che dovrebbero aumentare ulteriormente la situazione fino a quando non avranno capito se possono controllarla“, ha detto.

Fonte: New York Times

Il problema di questa affermazione è che gli scienziati del mondo collaborano supportati da una struttura politica che permette loro di avere accesso a fondi, infrastrutture e risorse senza le quali sarebbe impossibile procedere nella ricerca. Anche quando l’attività è supportata da un ente privato, il tessuto politico e statale è comunque presente seppur meno visibile. Non c’è necessariamente una negatività in questo, è solo un aspetto neutrale che può diventare tanto positivo, quanto negativo a seconda della condizione che si verifica nel caso specifico. Nel caso in oggetto bisogna tenere presente la pressione geopolitica che vede due schieramenti contrapposti: America e Cina. Anche internamente all’America la situazione è di forte concorrenza e lo stesso Hinton ne parla:

Molti altri esperti, inclusi molti dei suoi studenti e colleghi, affermano che questa minaccia è ipotetica. Ma il dottor Hinton crede che la corsa tra Google e Microsoft e altri si intensificherà in una corsa globale che non si fermerà senza una sorta di regolamentazione globale

Fonte: New York Times

Intanto qualche giorno fa la Casa Bianca ha chiamato i presidenti delle società Google, Microsoft e Open AI, in un colloquio con Kamala Harris, vicepresidente degli Stati Uniti.

È stata proprio la concorrenza a provocare quell’ipersviluppo a cui si faceva riferimento ad inizio articolo e che Hinton descrive come segue: “ho pensato che fosse lontano. Pensavo che mancassero dai 30 ai 50 anni o anche di più. Ovviamente non lo penso più.“

Durante un episodio del podcast The Robot Brains, Hinton si è sentito rivolgere alcune domande dal pubblico, tra cui la seguente:

[INTERVISTATORE] E ho una seconda domanda da Ilya, una domanda molto diversa. Ti sei mai preoccupato che l’IA stia diventando troppo vincente e troppo dominante?

[HINTON] Sì. Le due cose che mi preoccupano di più sono il suo utilizzo nelle armi perché consentirà a paesi come gli Stati Uniti, ad esempio, di avere piccole guerre all’estero senza vittime utilizzando soldati robot. Non mi piace quell’idea. Ancora peggio, il suo utilizzo nel prendere di mira particolari sottopopolazioni per far oscillare le elezioni. Quindi questo genere di cose è stato fatto da Cambridge Analytics e credo che sia stato molto influente sia nella Brexit che nell’elezione di Trump. Penso che sia davvero un peccato che tecniche come il deep learning rendano questo tipo di operazione più efficienti.

[INTERVISTATORE] La prossima domanda è di Eric Jang, in realtà, uno dei tuoi colleghi di Google. Quali sono le tre domande che ti tengono sveglio la notte? Non necessariamente limitato all’intelligenza artificiale.

[HINTON] Quand’è che il procuratore generale farà finalmente qualcosa? Questo mi tiene sveglio la notte. Perché il tempo sta per scadere. È quello che mi preoccupa di più. Come si comporta il mondo con persone come Putin che hanno armi nucleari? E il cervello usa la retropropagazione o no? In questo ordine.

Fonte: The Robot Brains – Episodio 22

Qui è possibile scaricare la trascrizione in italiano (tradotta da Google) dell’episodio ma anche quella inglese per confrontare ed escludere eventuali errori di traduzione.

Aspetti sociali e militari

L’utilizzo dell’intelligenza artificiale nel tessuto sociale si sta iniziando a declinare in molti modi: in questi giorni sta facendo molto discutere l’app (per la precisione un bot di Telegram) che, usando un algoritmo, finge di spogliare le persone mostrandole nude. Si chiama Bikini Off e richiama vecchi (e discutibili) costumi popolari in voga a tempi ormai passati in cui si vendevano occhiali con finti raggi infrarossi. C’è un interessante post su LinkedIn dell’Avv. Andrea Lisi sull’argomento; si tratterebbe pertanto, di una sorta di fotomontaggio con un elevato grado di realismo, che simula il corpo nudo delle persone. Vi consiglio anche un articolo su Red Hot Cyber intitolato “Realmente falso: Bikinioff, l’intelligenza artificiale che spoglia le donne“.

L’utilizzo dell’intelligenza artificiale per creare figure umane artefatte dall’aspetto fotorealistico e dai comportamenti altrettanto convincenti, potrebbe spingere alla creazione di contenuti di qualsiasi tipo, con un impatto più forte sulla psicologia delle persone. Chiaramente tutto è regolabile, tutto è assoggettabile a norma ma questo non risolve la complessità del problema, ne affronta solo una parte: il realismo delle immagini può ingannare la mente e modificare quei valori sociali (quelle che i filosofi chiamano leggi morali) che regolano la vita di tutti gli esseri umani.

Lungo la strada, è preoccupato che le versioni future della tecnologia rappresentino una minaccia per l’umanità perché spesso apprendono comportamenti inaspettati dalle enormi quantità di dati che analizzano.

Fonte: New York Times

La società ha già dimostrato di non essere all’altezza dell’innovazione tecnologica: l’impiego di tecnologie più semplici ed elementari, come gli smartphone e i social network, hanno dato origine a psicopatologie dovute alla mancata regolamentazione nell’uso dello strumento.

L’abuso dei social network può portare all’isolamento – spiega Ezio Benelli, presidente del congresso e dell’International Foundation Erich Fromm – l’utilizzo smodato e improprio del cellulare può provocare non solo divari enormi tra persone, ma anche a chiudersi in se stesse e a alimentare la paura del rifiuto

Fonte: “Allarme ‘nomofobia’, dipendenza da smartphone è malattia”, Ansa, (LINK)

Nelle macchine a guida autonoma, nonostante fosse esplicitamente scritto di non distrarsi dalla guida, ci sono stati casi di persone che hanno dormito in auto o guardato film, che sono morte o che comunque hanno genericamente messo a repentaglio la propria vita e quella di altri per aver seguito delle istruzioni precise. Non ci sono quindi le basi statistiche per sostenere che tale tecnologia non avrà anche impatti negativi, con la differenza che le conseguenze potrebbero essere fuori controllo e di enorme impatto. Più la tecnologia è complessa, più si presenta in modo “semplice” e più si tenderà a sottovalutarla e avrà impatti elevati. In merito all’ambito militare, Hinton è molto chiaro e prefigura uno scenario piuttosto evidente.

Questo diventa un problema, ha affermato, poiché gli individui e le aziende consentono ad I.A. sistemi non solo per generare il proprio codice informatico, ma anche per eseguirlo da soli. E teme un giorno in cui armi veramente autonome – quei robot assassini – diventeranno realtà.

Fonte: New York Times

Se la parola robot fa storcere il naso immaginando scenari apocalittici simili a quelli della serie Terminator, basti considerare che nessuna parte della sua definizione fa riferimento ad un aspetto antropomorfo.

Manipolatore riprogrammabile, multiscopo progettato per muovere oggetti, parti, attrezzi, o apparecchiature specializzate attraverso vari movimenti, programmati per l’esecuzione di una varietà di compiti. In informatica, software che analizza i contenuti di una rete (o di un database) in modo metodico e automatizzato, in genere per conto di un motore di ricerca. Il nome r. deriva dal ceco Robot, nome proprio, a sua volta derivato di robota «lavoro faticoso», con cui lo scrittore K. Čapek designava gli automi che lavorano al posto degli operai nel suo dramma fantascientifico R.U.R. (1920)

Fonte: Treccani

La paura di Hinton riguarda “comuni macchine” alimentate da software che possono essere alterate nel comportamento per commettere azioni assassine. Robot che sono di supporto all’essere umano e che possono essere trovate nelle fabbriche, nei magazzini, nelle basi militari, nelle sale operatorie, nelle officine, a diversi livelli di complessità e sicurezza.

Lavoro

C’è un tema decisamente più attuale sul quale Hinton si è espresso nettamente: il mondo del lavoro. L’intelligenza artificiale, al momento, sta supportando l’attività umana in molti settori: ricerca astronomica, ricerca medica, giustizia, etc… Hinton però ravvede un rischio in questa integrazione.

È anche preoccupato che I.A. le tecnologie col tempo sconvolgeranno il mercato del lavoro. Oggi, chatbot come ChatGPT tendono a integrare i lavoratori umani, ma potrebbero sostituire paralegali, assistenti personali, traduttori e altri che gestiscono compiti meccanici. “Toglie il lavoro faticoso”, ha detto. “Potrebbe portare via più di questo.”

Fonte: New York Times

Mentre si discute sul miglioramento delle condizioni di lavoro che la I.A. può portare alla società, sollevando l’essere umano dai carichi più gravosi e pericolosi per la salute, è necessario fare due riflessioni in merito.

La prima è che tale beneficio, perchè sia effettivamente tale, deve essere convertito in opportunità di miglioramento economico-sociale per la società. Negli ultimi trent’anni, ad esempio, la società italiana è migliorata in quanto a stili di vita, benessere, salute, ma il mercato del lavoro e i salari sono rimasti bloccati; questo genera un disequilibrio pericoloso e assolutamente indesiderabile.

La seconda è che, almeno al momento, ciò si sta traducendo in una serie di manovre ben poco apprezzabili sul mercato del lavoro. Il Corriere della Sera, il 2 maggio 2023, ha pubblicato un articolo intitolato “IBM sospende 7.800 assunzioni: i nuovi dipendenti saranno sostituiti dall’intelligenza artificiale”. La notizia ha fatto il giro del mondo, di seguito si riporta il titolo pubblicato da Bloomberg.

Allineamento e sterminio dell’umanità

Uno degli argomenti discussi intorno all’evoluzione dell’intelligenza artificiale, riguarda il possibile sterminio dell’umanità. È stata socialmente denominata sindrome Skynet in omaggio al film Terminator nel quale l’intelligenza artificiale Skynet distrugge la razza umana.

Il sistema andò online il 4 Agosto 1997. Skynet cominciò a imparare a ritmo esponenziale. Divenne autocosciente alle 2:14 del mattino, ora dell’Atlantico, del 29 Agosto, e lanciò i missili nucleari alle 18:18 ora di Los Angeles.

Fonte: Terminator

È però importante capire quanto sia realmente possibile questo rischio: certamente, infatti, l’intelligenza artificiale potrà agire anche su scala globale ma ciò non suggerisce un livello di minaccia immediata. Il 25 marzo 2023 Sam Altman, a capo di Open AI (la società che ha sviluppato Chat-GPT,) è stato intervistato nel podcast di Lex Fridman (puntata 367).

Al minuto 54:37 l’intervistatore (Lex Fridman) pone una domanda citando Eliezer Yudkowsky, un teorico dell’intelligenza artificiale molto noto negli Stati Uniti; l’intervistatore chiede ad Altman se si trova d’accordo con la teoria di Yudkowsky secondo la quale sarebbe impossibile tenere l’intelligenza artificiale allineata all’essere umano, in quanto tenderà alla super intelligenza. Il tema dell’allineamento è molto sentito dalla comunità che s’interessa di intelligenza artificiale perché in molti considerano la capacità evolutiva della I.A. come naturale conseguenza delle sue capacità elaborative. Questo superamento provocherebbe un fisiologico disallineamento alla base dello sterminio della razza umana. In merito a questo la risposta di Altman è interessante:

So, first of all, I’ll say I think that there’s some chance of that and it’s really important to acknowledge it because if we don’t talk about it, if we don’t treat it as potentially real we won’t put enough effort into solving it. And I thing we do have to discover new techniques to be able to solve it.

Dunque, prima di tutto, dirò che penso che ci sia qualche possibilità che questo accada e penso che sia realmente importante riconoscerlo perchè se non ne parlassimo, se non lo trattassimo come una potenziale minaccia reale, non potremmo mettere il giusto impegno nella risoluzione. E penso che dobbiamo scoprire nuove tecniche per poterlo risolvere.

Per comprendere bene la risposta di Altman, che è ben più complessa del testo sopra citato per ragioni di spazio, si raccomanda di ascoltare la parte specifica dell’intervista cliccando qui. L’audio del podcast, liberamente scaricabile, è stato caricato nel sito e riportato di seguito.

La problematica dell’allineamento è centrale nel discorso sull’intelligenza artificiale e non è stata ancora risolta: di conseguenza tutti gli scenari derivanti non sono da considerarsi improbabili, bensì potenzialmente probabili. Questo cambia la situazione radicalmente poiché, non potendo escludere con certezza il rischio espresso da Yudkowsky, Altman ne valuta l’eventualità e i relativi approcci. Nella successiva puntata del podcast di Lex Fridman (la puntata 368), Yudkowsky ha espresso questo concetto in merito all’allineamento:

The problem is that we do not get 50 years to try and try again and observe that we were wrong and come up with a different theory and realize that the entire thing is going to be like way more difficulta than realized at the start, because the first time you fail at aligning something much smarter than you are, you die.

Il problema è che non abbiamo 50 anni per provare e riprovare e osservare che ci sbagliavamo e inventare una teoria diversa e renderci conto che l’intera cosa sarà molto più difficile di quanto realizzato all’inizio, perché la prima volta che non riesci ad allineare qualcosa di molto più intelligente di te, muori.

Nella storia dell’uomo sono molti i casi in cui tecnologie e scoperte particolarmente rilevanti sono diventate anche armi di offesa, forse l’esempio più eclatante è la bomba nucleare. Tuttavia è anche importante notare che l’umanità non si è mai trovata minacciata da un “nemico esterno”; il caso più vicino è il Covid, che ha messo a rischio intere popolazioni. Nessuno può sapere se, nel caso di un’eventuale minaccia da parte dell’intelligenza artificiale, i paesi reagirebbero unendosi o spaccandosi: se potrebbero innescarsi quei meccanismi di solidarietà meccanica e organica di cui parlava Emile Durkheim, o se prevarrebbe la spaccatura e l’isolamento.

Eliezer Shlomo Yudkowsky (Chicago, 11 settembre 1979) è uno scrittore, teorico dell’intelligenza artificiale e teorico delle decisioni statunitense, noto per aver divulgato l’idea dell’intelligenza artificiale amichevole, rendendola popolare. È co-fondatore e ricercatore presso il Machine Intelligence Research Institute (MIRI), un’organizzazione di ricerca privata senza scopo di lucro con sede a Berkeley, in California.Il suo lavoro sulla prospettiva di un’esplosione di intelligenza incontrollata ha avuto un’influenza su Superintelligence: Paths, Dangers, Strategies di Nick Bostrom. Il punto di vista di Yudkowsky sulle sfide alla sicurezza poste dalle future generazioni di sistemi di IA è discusso nel libro di testo universitario di Stuart Russell e Peter Norvig, Artificial Intelligence: A Modern Approach. Notando la difficoltà di specificare formalmente gli obiettivi generali a mano, Russell e Norvig citano la proposta di Yudkowsky che i sistemi autonomi e adattivi siano progettati per imparare un comportamento corretto nel tempo:

«Yudkowsky (2008) entra più in dettaglio su come progettare una IA amichevole. Egli afferma che la gentilezza (un desiderio di non nuocere agli umani) dovrebbe essere progettata fin dall’inizio, ma che i progettisti dovrebbero riconoscere sia che i loro progetti possono essere difettosi, sia che il robot imparerà ed evolverà nel tempo. Quindi la sfida è quella della progettazione dei meccanismi: progettare un meccanismo per l’evoluzione dell’IA sotto un sistema di controlli ed equilibri, e dare ai sistemi funzioni di utilità che rimarranno amichevoli di fronte a tali cambiamenti. In risposta alla preoccupazione della convergenza strumentale, in cui i sistemi decisionali autonomi con obiettivi mal progettati avrebbero incentivi predefiniti a maltrattare gli esseri umani, Yudkowsky e altri ricercatori MIRI hanno raccomandato di lavorare per specificare gli agenti software che convergono su comportamenti predefiniti sicuri anche quando i loro obiettivi sono mal specificati.»

Fonte: Wikipedia

Conclusioni

Le dimissioni di Hinton stanno facendo discutere e questo è un bene: stanno accendendo un faro ancora più luminoso su una tecnologia che dovrebbe nascere in un contesto più riparato e con una regolamentazione più stringente. La I.A. ha dimostrato una impressionante utilità in contesti quali la medicina, la scienza, ma anche nelle applicazioni della vita di tutti i giorni. È necessario ribadire un concetto: semplicità d’uso non significa banalità. Tecnologie ben più semplici dell’intelligenza artificiale richiedono agli umani un periodo di apprendimento e talvolta una licenza: guidare un’automobile, pilotare un aeroplano, persino attraversare la strada o usare le posate a tavola sono cose che richiedono un periodo di apprendimento ed il rispetto di alcune regole.

L’intelligenza artificiale deve essere considerata come una straordinaria opportunità per il genere umano, può supportare le persone nel quotidiano e migliorare le condizioni di vita su larga scala. Sarebbe strano implementare una tecnologia così impattante e renderla accessibile senza (in)formare adeguatamente le persone, senza prepararsi adeguatamente alle complessità. Sarebbe irresponsabile implementarne massivamente l’uso solo per inseguire l’opportunità commerciale.

Approfondimenti

È caldamente consigliata la lettura di un articolo scritto da Carola Frediani sul suo portale e intitolato “Geoff Hinton è uscito dal gruppo”, lo trovate qui.

Se volete approfondire il lavoro di Hinton fatto nel periodo di Google, c’è un elevato numero di pubblicazioni che trovate qui.