C’è una domanda che raramente viene rivolta a chi si occupa di intelligenza artificiale: è possibile e corretto considerare l’uomo alla stregua di una macchina? È una domanda piuttosto particolare a cui, dopo la II Guerra Mondiale, i cognitivisti hanno provato a rispondere.

L’obiettivo della domanda è semplice: se l’uomo è assimilabile ad una macchina, allora altre macchine possono supportarlo in ogni aspetto dei suoi processi quotidiani. Se l’uomo non è assimilabile ad una macchina, in tutto o in parte, il supporto potrà essere solo parziale se non addirittura impossibile.

Obiettivo dell’articolo

L’obiettivo di questo articolo è quello di dimostrare come negli anni si siano succedute teorie contrastanti in merito a concetti come memoria, pensiero, ragionamento e come tali differenze abbiano portato alla formazione della disciplina che oggi chiamiamo intelligenza artificiale. Il lettore si troverà a leggere teorie contrastanti, anche di difficile comprensione ma ritenute validi spunti critici dalla comunità scientifica. Bisogna infine tenere conto che tali teorie si sono sviluppate in un periodo di grande sviluppo delle branche tecnico-umanistiche che collaboravano maggiormente rispetto ad oggi.

L’uomo come servomeccanismo

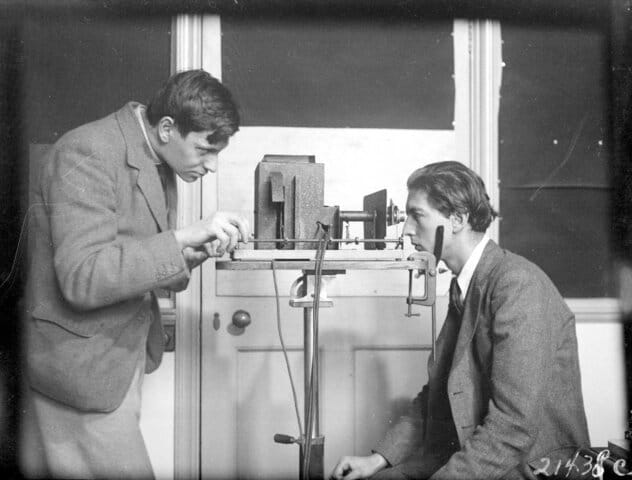

K.J. Craik è stato uno psicologo scozzese. Nelle sue ricerche iniziò a considerare l’uomo al pari di un servomeccanismo e per confermare questo suo pensiero esegue un semplice test: chiese ad alcuni soggetti di mantenere lo sguardo fisso su un bersaglio in movimento.

Tramite l’esperimento Craik dedusse che il soggetto umano, durante il test, non è in grado di operare più di una correzione ogni mezzo secondo e durante questo mezzo secondo il soggetto non è in grado di elaborare nuove informazioni fino a quando non sono state elaborate le precedenti. Questo esperimento portò a tre conclusioni importanti:

- l’uomo è assimilabile ad un elaboratore di informazioni, un servomeccanismo di tipo cibernetico;

- l’uomo ha un tipo di funzionamento discreto;

- il meccanismo decisore è unico, e durante il processo non potevano essere eseguite più cose alla volta.

La posizione di Craik fu forte e suscitò clamore nell’ambiente accademico: ancora oggi non si possono trascurare i risultati e le conclusioni a cui è arrivato. Tra l’altro questo esperimento pose al centro un altro elemento che si era da tempo accantonato: il tempo come fattore principale di riferimento. Però, allo stesso tempo, è difficile concepire l’uomo come “macchina”, come “servomeccanismo” ed è chiaro che, seppur vincolato al tempo e alla decisione di quel “mezzo secondo”, l’uomo è anche altro. Craik formulò una spiegazione articolata del fenomeno nella quale, ad un certo punto, scrisse:

Vi è qualcosa di meraviglioso nell’idea che il cervello dell’uomo sia la più grande delle macchine, in quanto imita nella sua finissima rete eventi che si verificano nelle stelle più distanti. Ne prevede con precisione la comparsa, e trova in questa capacità di previsione corretta e di comunicazione la caratteristica ultima della coscienza. (K.J. Craik)

Nel 1944 Craik ricevette critiche molto aspre sulla sua teoria così deterministica da parte di coloro che vedevano nell’agire dell’uomo una spiegazione differente e indeterminata. Per tacitare le critiche, domandò ai suoi detrattori di rispondere ad un questionario composto da alcune domande, una di queste era:

Pensate che si possa sempre distinguere chiaramente tra un atto che siamo fisicamente costretti a compiere e un atto che si scegliere volontariamente di compiere?

La domanda non posta da Craik è scontata e offrì allo psicologo la possibilità di spiegare fenomeni semplici (come lo stimolo-risposta) ma anche quelli più complessi (che risultavano una combinazioni di quelli semplici). La teoria di Craik condizionò fortemente il dialogo degli anni successivi, talmente tanto da provocare discussioni sullo sviluppo della cibernetica e dei modelli cognitivo-comportamentali. La posizione di Craik era chiara: tutto poteva essere tradotto in una sequenza di ragionamenti più “piccoli” ed “elementari”, persino i processi cognitivi più elevati, complessi e misteriosi. La posizione dello psicologo era dichiaratamente deterministica e rifiutava di introdurre la casualità all’interno della psicologia: era come scombinare una serie di reazioni senza un motivo sufficiente. Craik operò una distinzione netta tra mente (come elemento che genera processi) e corpo (come elemento che esegue i processi): c’è una parte dell’organismo soggetta a controllo da una parte che effettua questo controllo. Il controllo viene eseguito mediante i potenziali d’azione delle cellule nervose che, a loro volta, agiscono sulle cellule contigue mediante depolarizzazione o iperpolarizzazione.

L’uomo come elemento chimico-fisico

Alla posizione di Craik risponderà J.S. Griffith (chimico) che rinuncerà a considerare il cervello alla stregua di un servomeccanismo o di un calcolatore elettronico e favorirà la teoria che il cervello agisce sulla base della sua composizione cellulare e organica e quindi seguendo un principio chimico-fisico. È una posizione importante, diversa da quella di Craik per quanto similare: vi è comunque un nesso tra il pensiero e l’agire, ma per Griffith questo nesso è rappresentato dalla composizione chimica delle cellule che provocano differenti risultati. Per molti il modello fu considerato troppo semplicistico nonostante offrisse alcuni spunti interessanti:

- Rispetto a Craik il modello di Griffith era maggiormente suddivisibile (in base alla composizione chimica delle cellule).

- Nella sua semplicità riusciva comunque a spiegare le differenti interazioni tra cellule tra loro eterogenee.

Tuttavia vi era un importante limite in questa teoria: non vi erano spiegazioni sui comportamenti più complessi, a parte quelli riguardanti lo stato di quiete e di eccitazione neuro-cellulare. Ciò portò molti detrattori a considerare la teoria di Griffith come “grossolana” anche se non del tutto errata.

Il riflesso condizionato come processo complesso e non “semplice”

Nel panorama conflittuale che è stato fin qui descritto vi è un ulteriore tassello da inserire che, almeno in apparenza, sembrerebbe bilanciare le due correnti. Il Prof. K.S. Lashley condusse numerosi studi sulla memoria (precisamente sugli engrammi), fornendo una spiegazione semplice ma utile a capire di cosa trattavano le sue analisi.

Quando la mente vuole richiamare un ricordo, questo atto di volontà fa sì che la piccola ghiandola pineale, inclinandosi successivamente in direzioni diverse, diriga gli spiriti animali verso diverse parti del cervello, fino a che incontrano la parte ove sono depositate le tracce dell’oggetto che si desidera ricordare. (K.S. Lashley)

Gli studi sulla memoria sono partiti dal fenomeno che si riteneva più elementare: lo stimolo-risposta. Si tratta di un’azione-reazione che il cervello ricorda e mette in atto automaticamente, quasi in modo inconsapevole, così immediatamente da considerarlo come processo elementare, alla stessa stregua di quello che sottintendeva Craik come servomeccanismo. Fino a quel momento, infatti, si riteneva che lo stimolo-risposta fosse così tanto basilare da costituire l’unità elementare del pensiero (cosa che si sarebbe potuta adattare molto bene alla teoria di Craik). Gli esperimenti di Lashley, tuttavia, evidenziarono altro:

Per alcuni anni ho lavorato come sperimentatore e come soggetto da esperimento in ricerche con il metodo salivare di Pavlov e con le reazioni motorie di Bechterew. Durante questo lavoro mi sono convinto che, lungi dall’essere una semplice reazione sensitivo-motoria, il riflesso condizionato è molto complesso.

Le conclusioni a cui arrivò Lashley sono una nuova rottura degli schemi che apparivano consolidati: se inizialmente il processo stimolo-risposta appariva basilare, semplice e predeterminabile, con gli esperimenti di Lashley esso risultò come l’insieme di una moltitudine sottilissima di sotto-processi.

Bionica e intelligenza artificiale

Nel 1964 Norbert Wiener propose la costruzione di una memoria artificiale organica (basata su acidi nucleici) da installare direttamente all’interno dei circuiti dei calcolatori elettronici. Si sarebbe trattato, con estrema semplificazione, di dotare una macchina artificiale di un apparato mnemonico organico (generato chiaramente all’esterno di un organismo vivente) al fine di massimizzarne l’efficienza. La bionica è la “scienza che studia le funzioni sensorie e motorie degli organismi viventi, al fine di individuare soluzioni sofisticate per problemi tecnici e di riprodurle o potenziarle con dispositivi elettronici” (Treccani). La bionica quindi è un potenziale approccio all’intelligenza artificiale.

La proposta di Wiener fu fortemente apprezzata dalla comunità scientifica che nel tempo ha cercato di comprendere come realizzare supporti mnemonici costituiti di materiale organico su vasta scala. Ci sono stati molti studi a questo proposito: uno tra i tanti è il celebre “Overview of organic memory devices” di D. Prime e S. Paul pubblicato nel 2009 dal Royal Society Journal. L’approccio di Wiener è ad un livello più alto rispetto gli altri autori fin qui citati: lo scopo è creare la fusione tra due apparati (organico e sintetico) considerati efficienti al massimo delle possibilità.

Intelligenza artificiale e computer quantistici

Nel corso degli anni le teorie si sono affinate e avvicendate, creando discipline che fungono da sovrastrutture di “collaborazione”: un esempio tra tutte è la neuroscienza che mette insieme varie branche tecnico-umanistiche al fine di armonizzare la conoscenza e trasferirla nello studio neurologico.

Quando si pensa all’intelligenza artificiale, quindi, al di là dei modelli statistico-matematici, non si può non includere anche elementi di profonda indeterminazione. Tali elementi non sviliscono la disciplina ma la rendono più interessante; Lashley, Griffith, hanno dimostrato come la complessità e l’apparente casualità entrano praticamente nella vita quotidiana del pensiero e dell’agire della mente.

Un ulteriore fenomeno da tenere in considerazione è stato la “rivincita” del fattore “tempo” sull’analisi di pensiero e comportamento. Craik aveva riportato il tempo al centro del problema: quel mezzo secondo era un elemento determinante per il soggetto sottoposto al test. Evidentemente non aveva torto: il tempo è ritenuto fondamentale nell’equazione di creazione di tecnologie intelligenti. È parte del risultato finale di cui non si può fare a meno. In alcuni appunti di lezione del Prof. Rahul Simha del Dipartimento di Computer Science alla George Washington University, si apprende che le applicazioni principali della computazione quantistica sono due:

- La promessa di calcoli più veloci per la risoluzione dei problemi.

- La promessa di una sicurezza inviolabile (per la sua complessità).

È da notare che l’aumento della complessità di calcolo, in ambito sicurezza, significa spesso allungare così tanto i tempi delle violazioni da renderle inutili. Anche in questo caso il fattore tempo è sottinteso e gioca un ruolo rilevante.

Conclusioni

I dubbi non sono stati sciolti, il confronto scientifico su molti dei temi sollevati da Craik, Griffith, Lashley, Wiener è tutt’altro che risolto ma è indubbio il tentativo della scienza di integrare l’ambito sintetico con quello organico (quantomeno a livello teorico). Ve ne sono le prove, vi sono gli studi, vi sono anni di confronti accademici: che si lavori nel campo della bionica o in quello dell’intelligenza artificiale, prima o poi è naturale imbattersi nell’eventualità di fondere i due mondi. Di trovare l’equilibrio tra il mondo sintetico e quello organico. È altresì indubbio che nell’uomo convivono complessità eterogenee, nessuna delle quali si può imbrigliare in una singola teoria; il che porta Griffith e Craik ad avere ragioni valide sulle quali basare le loro teorie, ambedue straordinarie a seconda del contesto osservato. A causa di tutta questa complessità, nota da oltre cento anni, è necessario manifestare cautela nell’esplorazione di quella che probabilmente è la più straordinaria scoperta umana degli ultimi secoli: l’intelligenza artificiale.